Підібрати правильні ключові слова, викинути зайве, прибрати картинки, обрати правильний шрифт – саме такі поради можна почути від експертів з підготовки резюме. Чому більшість рекомендацій мають технічний характер? По-перше, єдиний формат робить перегляд зручнішим для працедавця. По-друге, і найважливіше, більшість резюме оцінюють автоматизовані системи. Дослідження ілюструють, що більше 90% компаній користуються системами, які автоматично пріоритезують резюме: від найбільш доречних до зовсім нерелевантних.

Не за горами повсюдне використання таких систем і на теренах України. Як наслідок, у мережі вже можна знайти 1000 і 1 правило того, як потрапити у фаворити систем автоматичного перегляду і відбору резюме.

Втім, наразі ми поговоримо не про те, як обдурити систему штучного інтелекту та отримати роботу мрії. У консультації ми з’ясуємо, чи дружніми є подібні алгоритми до прав людини та що варто робити, якщо ви підозрюєте, що ваші права порушені.

Як працюють такі системи та якими є підводні камені?

Системи автоматичної оцінки та відбору резюме функціонують на основі штучного інтелекту. Алгоритми переважно побудовані таким чином, що релевантність резюме визначається за наявністю чи відсутністю ключових слів.

Більш просунуті системи оцінюють не лише ключові слова, а і їхній контекст – це допомагає уникнути шахрайства і підвищити точність. Деякі – навіть аналізують потенційну успішність кандидатів у компанії. Критеріїв для аналізу може бути безліч. Вони варіюватимуться залежно від потреб працедавця, включаючи освіту, наявність конкретного досвіду роботи чи певних рис у кандидата, готовність працювати повний день тощо. Після оцінки за заданими критеріями система послідовно розташовує резюме кандидатів від найбільш доречного до найменш релевантного. Відповідно, працедавці навряд запросять на співбесіду кандидатів з нижньої частини списку.

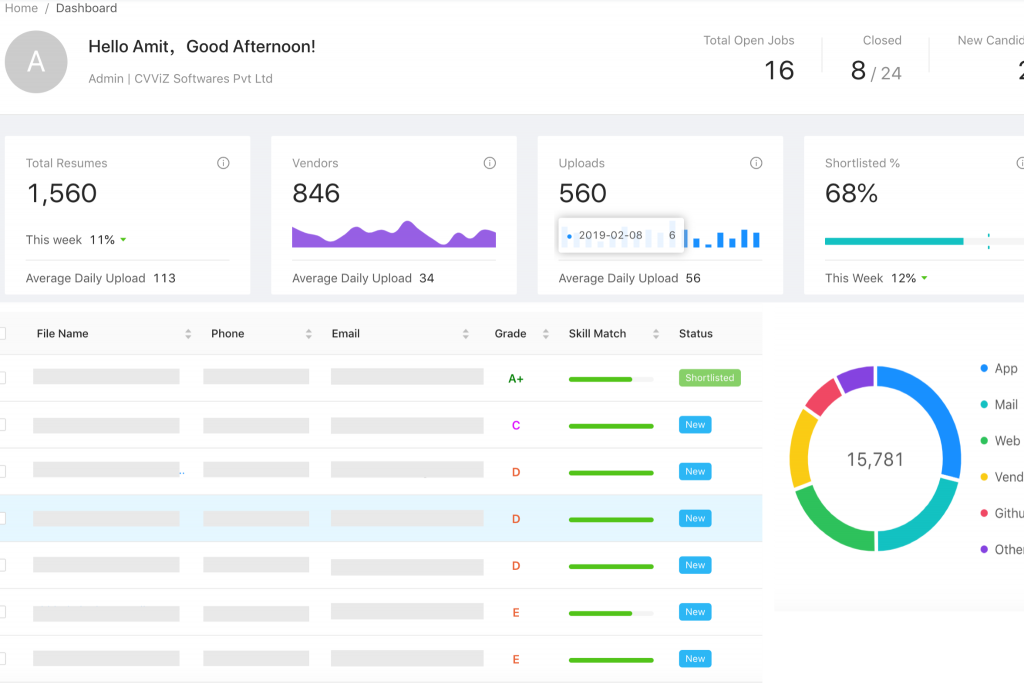

Приклад роботи системи автоматичного відбору резюме.

Здавалося б, механізм нічим не відрізняється від оцінки резюме людьми. Ба більше, системи відбору резюме побудовані за принципом машинного навчання. Це означає, що алгоритм оновлюється завдяки вивченій інформації та вибудовує нові правила поведінки, відстежуючи причинно-наслідкові зв’язки у даних, що надходять. То в чому ж полягає небезпека?

Наприклад, Amazon за час використання системи автоматизованого відбору резюме на технічні посади виявив невтішну тенденцію – жіночі резюме автоматично позначалися як такі, що мають вади чи є недостатньо хорошими. Проблема полягала у тому, що при навчанні системи використовували професійні характеристики, які можна частіше знайти у чоловічих резюме (англ. “executed”, “captured” та інші, що використовуються на позначення переважно чоловічих характеристик). Таким чином, резюме без цих слів оцінювалися нижче – нерівність несвідомо заклали у першопочатковий алгоритм, а машинне навчання лише підживлювало її. В українському контексті подібна ситуація може трапитися, якщо в алгоритм закладуть характеристики чоловічого роду (“стресостійкий”, “наполегливий” та “старанний” без форми “стресостійка”, “наполеглива” та “старанна”).

Часто ж проблема є ще глибшою, адже критерії для відбору можуть розробляти самі працедавці. І вони можуть включати “безперервність у робочому стажі”, що автоматично виключатиме жінок, які брали декретну відпустку чи відпустку з догляду за дитиною. Іншим прикладом є орієнтування реклами з пропозиціями роботи на чоловіків, як це сталося з вакансією водія таксі та рекламою на Facebook.

Іншою проблемою є вікова та расова дискримінація. До прикладу, в американському штаті Іллінойс резюме кандидатів з освітою, отриманою до 1980 року, автоматично відсіювалися, адже система вважала їх менш вдалою опцією. Схожа проблема була і у Facebook, де запити від “людей кольору” (англ. “people of colour”) система ігнорувала або ж пріоритезувала з мінімальним індексом. Іншим прикладом є велике дослідження щодо дискримінації арабів при прийомі на роботу – практики, яка з живих інтерв’ю та переглядів резюме перекочувала у механізми алгоритмів. Як наслідок, такі люди не отримували роботу, хоч за всіма характеристиками і формальним оформленням резюме повністю відповідали оголошеній посаді.

Крім цього, іноді дискримінаційні практики взагалі можуть базуватися лише на імені кандидата, яке дозволяє визначити і стать, і етнічну приналежність. Таким чином, якщо в житті буде відбуватися, як у відомому експерименті – набір переважно білих людей – алгоритм сприйме це як належну модель поведінки. Якщо ж алгоритм наповнений упередженою інформацією, його використання лише посилить інституційну дискримінацію. Іншою проблемою є відсутність даних про певні групи і нерепрезентативність наявної інформації, яка спричиняє дискримінаційні практики.

Український контекст та іноземне регулювання – у пошуках стандартів

Автоматична обробка резюме зачіпає дві ключові сфери – трудове право та захист персональних даних. Якщо ж говорити про недоліки алгоритмів чи свідоме зловживання ними з боку працедавців, постане ще одне питання – протидія дискримінації. Чи українське законодавство надає достатньо гарантій і запобіжників?

Кодекс законів про працю детально не регламентує особливості прийому осіб на роботу. Цей нормативний акт лише містить загальну норму щодо заборони дискримінації у будь-якій формі у сфері праці – вона стосується як безпосередньої реалізації посадових обов’язків, так і моментів прийому на роботу.

Чинний Закон України “Про захист персональних даних” також описує право особи на захист від автоматизованого рішення, яке може мати для неї правові наслідки. Втім, це положення не деталізоване ані в самому акті, ні у судовій практиці. Отже, конкретної правозахисної норми українське законодавство не передбачає, тому працедавці наразі можуть вільно використовувати автоматизовані системи відбору резюме.

Як щодо міжнародних стандартів? Нещодавно Європейська комісія опублікувала пропозиції щодо регулювання штучного інтелекту, розподіливши ризиковість технологій залежно від сфер їхнього використання. Галузь працевлаштування опинилася у категорії високого ризику, адже помилка може суттєво вплинути на права і свободи людини.

Подібний підхід можна відстежити і у Рекомендації Ради Європи, де значну увагу приділили небезпеці дискримінаційних практик при використанні автоматизованих систем. Втім, жорсткого конвенційного регулювання автоматичного відбору резюме на міжнародному рівні не існує.

Час для паніки: ми всі станемо безробітними!

Ні, не час. Загалом системи автоматизованого відбору резюме, маючи високий рівень ризику, все ж не є базово несумісними зі стандартами у сфері захисту прав людини. А тому ключовим питанням залишається наявність конкретного регулювання на державному рівні. Хоч в Україні наразі і нема деталізованого механізму з цього питання, слід пам’ятати про декілька важливих аспектів:

- На більшість міжнародних компаній поширюють свою дію статті 21 та 22 GDPR (Загального регламенту про захист персональних даних). Вони передбачають можливість заперечити щодо використання автоматизованих систем для обробки персональних даних та вимоги здійснити таку саму операцію за допомогою людського ресурсу. По суті, компанія має забезпечити особу правом перегляду рішення людиною, правом висловити власну думку та оскаржити таке рішення;

- У парламенті зареєстровано законопроєкт №5628 про захист персональних даних, котрий передбачає імплементацію положень GDPR в українське законодавство. ЦЕДЕМ рекомендує парламенту прийняти законопроєкт, що зможе зарадити і у ситуації відбору резюме, адже суттєво посилить захист персональних даних та створить зобов’язання для належної технічної організації таких систем;

- Компаніям не варто відмовлятися від обов’язкового перегляду рішень автоматизованих систем відбору резюме людиною та регулярних перевірок справності алгоритмів – щодо наявності технічних несправностей, хиб внаслідок машинного навчання або ж системних дискримінаційних практик. Системи ж слід наповнювати гендерно нейтральною лексикою та видаляти пріоритети, що можуть послугувати підставою для дискримінації.

- Кандидатам варто пам’ятати про свої права та вимагати перегляду рішень автоматизованої системи у випадку, якщо вони мають підозру про порушення їхніх прав.

Зрештою, доки системи не є ідеальними з технічної точки зору, вони не будуть відповідати і стандартам у сфері захисту прав людини. Саме тому потрібно пам’ятати про усі підводні камені та спільно шукати рішення, а доки його не знайдено – не вважати штучний інтелект панацеєю у сфері працевлаштування.

Ця консультація була розроблена ЦЕДЕМ в рамках Technical Assistance Support в Україні, що здійснюється European Center for Not-for-Profit Law Stichting (ECNL). Проект став можливим завдяки підтримці International Center for Not-for-Profit Law (ICNL) через Civic Space Initiative.

Ця публікація повністю фінансується урядом Швеції. Уряд Швеції не обов’язково поділяє викладені тут думки. Автор несе виключну відповідальність за зміст.