Темпи розвитку штучного інтелекту (ШІ) не перестають дивувати. Вже зараз світ розділився на два табори: одні закликають зупинити розвиток потужних систем штучного інтелекту, інші анонсують про інтеграції чат-ботів зі штучним інтелектом “СhatGPT” у свої платформи. Вплив ШІ на різні сфери нашого життя стає набагато потужнішим, і це вимагає врегулювати його на законодавчому рівні. Довгий час люди не надавали значення такому регулюванню, проте зараз воно необхідне як ніколи. Його відсутність може призвести до великої кількості порушень безпеки персональних даних, потенційної дискримінації користувачів, загрози створення ШІ для військової агресії та інших негативних наслідків.

Аби зрозуміти, як регулюватиметься створення та використання штучного інтелекту, Центр демократії та верховенства права пропонує докладний аналіз Artificial Intelligence Act (далі – AI Act), законопроєкту, запропонованого у квітні 2021 року Європейською комісією.

ШІ провокує скандали

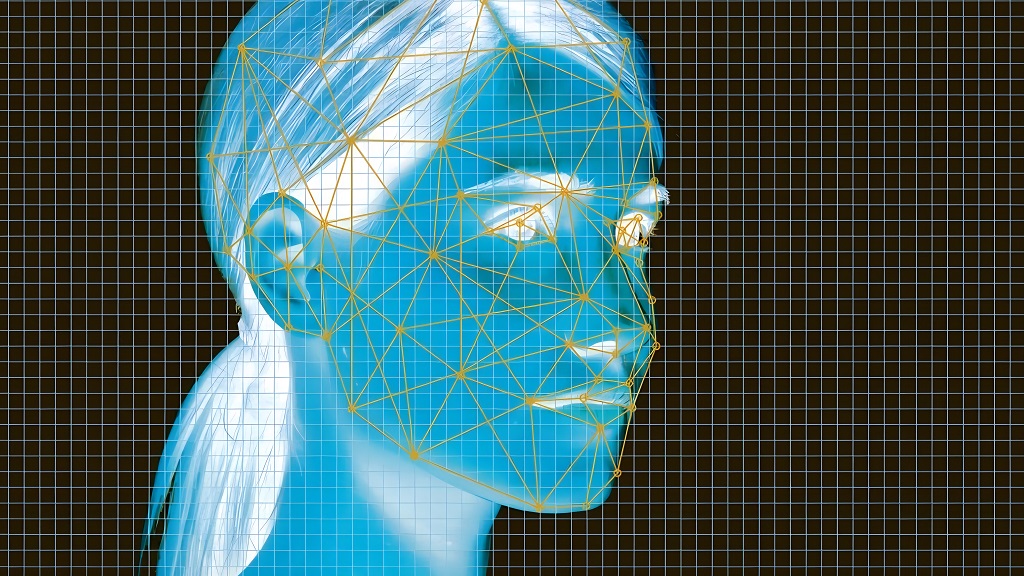

У січні 2020 року спалахнув скандал: компанія Clearview AI збирала та зберігала мільйони фотографій користувачів з соціальних мереж, включаючи Facebook, Instagram та Twitter, без їхньої згоди. Це – порушення права на приватність користувачів. Багато людей були занепокоєні тим, що їхні фотографії та особиста інформація можуть бути використані проти них.

Clearview AI – компанія, яка створила програму розпізнавання облич з використанням штучного інтелекту. Вона збирає дані з різних джерел, створюючи велику базу даних з фотографіями та інформацією про обличчя людей.

Джерело: Biometric Update.com

Засновник Clearview AI Хоан Тон-Тхат повідомив, що компанія провела більше мільйона пошукових запитів для поліції США. Вони продають доступ до своєї бази даних правоохоронним органам та мають більше 3100 активних користувачів, включаючи Федеральне бюро розслідувань та Департамент безпеки США.

Через таку діяльність до Clearview AI подали об`єднаний груповий позов, в якому компанію звинуватили у продажі без згоди біометричних відбитків осіб правоохоронним органам. У позові зазначалось, що Clearview AI неодноразово порушувала Закон “Про конфіденційність біометричної інформації” штату Іллінойс (він, зокрема, визначає, що біометричні ідентифікатори мешканців штату Іллінойс, включно з зображенням облич, не будуть зібрані та використані без їхнього відома та дозволу.

З іншого боку, зараз Україна використовує програмний комплекс від компанії Clearview AI. За його допомогою ідентифікують росіян, що здійснювали воєнні злочини в Україні. Саму технологію почали використовувати на території України ще у березні 2022 року. Правоохоронні органи США також продовжують використовувати програму.

Така неоднозначність породжує багато питань. З одного боку, деякі технології ШІ дійсно порушують права людей, а з іншого, – це неймовірне досягнення, яке полегшує ідентифікацію людей у важливих випадках (наприклад, щоб затримати небезпечного злочинця). Тобто проблема – не штучному інтелекті як такому, а відсутності належного правового регулювання.

Україна та регулювання ШІ

В грудні 2020 року Кабінет Міністрів України затвердив концепцію розвитку штучного інтелекту в Україні. В ній зазначено про необхідність доопрацювати питання щодо регулювання суспільних відносин у сфері розвитку ШІ. Наразі в Україні найбільше дискусій викликає питання того, кому належать авторські права на твір, створений ШІ та тема захисту персональних даних.

Діяльність ШІ може підпадати під дію закону України “Про захист персональних даних”. Закон містить вимоги щодо обробки персональних даних, зокрема щодо їх збору, зберігання, використання, передачі та захисту. Так, за допомогою ШІ можуть здійснюватись автоматичні процеси збору та обробки персональних даних, наприклад, для аналізу поведінки користувачів на сайті або для розробки персоналізованих рекламних кампаній.

Також в Україні твори ШІ підпадають під регулювання Закону України “Про авторське право і суміжні права”. Результати діяльності ШІ можуть регулюватись безліччю інших законів, проте в цьому регулюванні не завжди враховані всі особливості такого інноваційного продукту як ШІ. Тому виникла необхідність підготовки AI Act, який би зміг комплексно врегулювати розробку та застосування штучного інтелекту.

Велика кількість програм ШІ обробляє персональні дані громадян ЄС, тому вони також підпадають під регулювання GDPR.

GDPR (General Data Protection Regulation) – Загальний регламент про захист даних 2016/679, спрямований на захист фізичних осіб стосовно обробки персональних даних та вільний рух таких даних. Раніше ми детально описали цей акт у статті “CCPA* ТА GDPR**: Концептуально про захист персональних даних”. Якщо компанія обробляє персональні дані європейських громадян, то вона повинна дотримуватися вимог GDPR, незалежно від того, де знаходиться.

Враховуючи сказане вище, компанія з України, яка обробляє персональні дані європейських громадян, також підпадає під дію GDPR. Таким чином, GDPR є важливим регулювальним актом не тільки для країн ЄС, а й для всіх компаній, що працюють з європейськими даними, у тому числі і для українських.

Зараз Україна бере участь в імплементації акту шляхом запровадження регуляторних пісочниць, про які йтиме мова трохи нижче.

Що таке AI Act?

Artificial Intelligence Act – це законопроєкт Європейського Союзу, мета якого створити безпечне середовище для використання та розвитку ШІ. AI Act став відповіддю на потребу в регулюванні технологій штучного інтелекту та їхнього впливу на суспільство через стрімкі темпи розвитку ШІ.

Зараз AI Act перебуває на стадії обговорення та надання пропозицій змін. 6 грудня 2022 року Рада ЄС ухвалила спільну позицію щодо AI Act. Це дозволило перейти до переговорів з Європарламентом після того, як він прийняв власну позицію. Після того, як Рада ЄС та Європейський парламент ухвалять спільну версію тексту, він зможе стати законом. Наразі депутати надали пропозиції до AI Act (наприклад, про те, що чат-боти повинні повідомляти користувачам, що вони не є людьми). За словами депутата Європейського парламенту Брандо Беніфея, парламентарі хочуть більшої прозорості. Тепер, після того, як парламент узгодив свою позицію, держави-члени, Європейська комісія та депутати Європарламенту спільно розроблять остаточний законопроект, щоб ухвалити його до кінця поточної каденції Європарламенту в 2024 році.

“Ми хочемо публічного розкриття списку матеріалів, які використовуються для його навчання, тому що [автори] можуть використовувати інші закони і шляхи, щоб спробувати отримати гроші за те, що використовується без їхньої згоди”, – сказав депутат Європарламенту Беніфей.

Згідно з цим законопроєктом, використання штучного інтелекту має бути обмежене для систем, що можуть мати “соціально небезпечні” та “маніпулятивні” властивості. До таких систем відносять той штучний інтелект, що ставить під загрозу права та свободи людини. Наприклад, у 2018 році було виявлено, що система найму на Amazon, яка використовувала штучний інтелект для відбору кандидатів на роботу, дискримінувала жінок, відхиляючи їхні резюме через стать. Також передбачено вимогу щодо “людського контролю” над певними системами ШІ, особливо тими, що можуть впливати на життя та здоров’я людей.

Законопроєкт має сприяти створенню такого середовища для використання систем штучного інтелекту, де користувачі можуть бути впевнені, що їхні права будуть захищені, а відповідальність за негативні наслідки буде нести розробник чи постачальник системи ШІ.

Основні положення AI Act

AI Act складається з 12 розділів, кожен з яких регулює окрему сферу застосування та розробки штучного інтелекту. Цей законопроєкт має екстериторіальний характер, тому його положення можуть бути застосовані і до тих компаній-розробників ШІ, які перебувають поза межами Європейського Союзу.

Основні положення цього законодавчого акта передбачають:

- Визначення рівнів ризику систем ШІ (детальніше про такі рівні ризику – далі в аналітиці).

- Введення обов’язкової сертифікації для певних систем ШІ. До таких систем належать, наприклад, системи біометричної ідентифікації, критичної інфраструктури, освітні або професійні оцінювальні системи.

- Встановлення вимог для певних систем ШІ щодо необхідності інформування користувачів про те, що вони взаємодіють з системою ШІ, а не людиною.

- Встановлення правил прозорості для систем ШІ, призначених для взаємодії з фізичними особами, систем розпізнавання емоцій, а також систем ШІ, які використовуються для створення або оброблення зображень, аудіо- або відеоконтенту.

- Створення єдиного європейського ринку ШІ. Це передбачає введення єдиних правил для роботи з технологіями ШІ на території ЄС, що сприятиме вільному руху систем ШІ та послуг на європейському ринку.

- Заборону на використання певних методів штучного інтелекту.

Класифікація систем штучного інтелекту

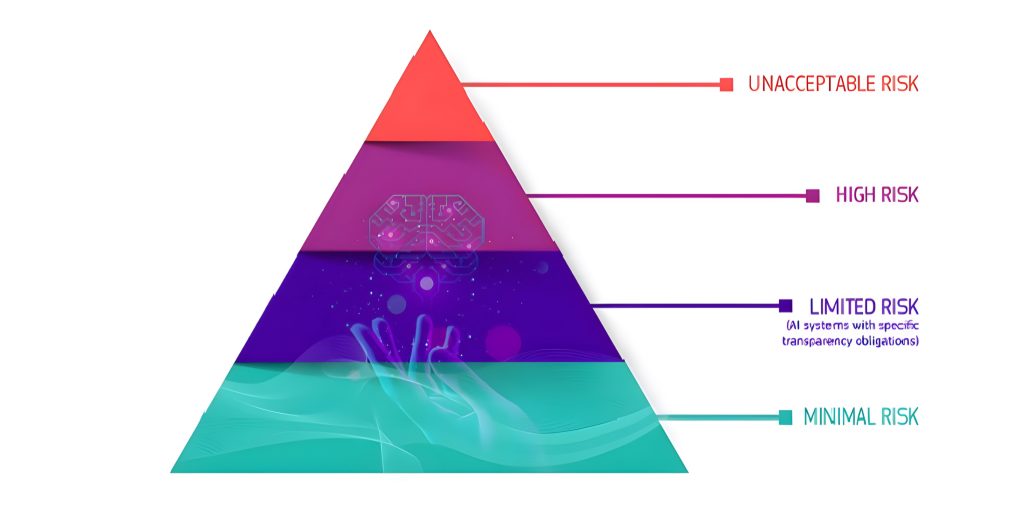

У AI Act програми штучного інтелекту класифікуються за ступенем ризику і регулюються відповідно до цього критерію. Тобто він ґрунтується на ризик-орієнтованому підході, який класифікує системи штучного інтелекту за п’ятьма категоріями, зазначеними на сайті Європейської комісії:

- заборонені системи ШІ;

- системи ШІ з високим ступенем ризику;

- системи ШІ з обмеженим рівнем ризику;

- системи ШІ з мінімальним ризиком або не ризикові;

Джерело: офіційна сторінка Європейської комісії

Все регулювання, переважно, залежить від того, до якого рівня ризику належить система ШІ, тому розглянемо кожен рівень ризику детальніше.

Мінімальний ризик або не ризиковий: Цей рівень стосується систем ШІ, які не мають значного впливу на користувачів та їхні права. Прикладами таких систем можуть бути персональні помічники, рекомендаційні системи, віртуальні асистенти та інші розважальні програми. AI Aсt не вводить додаткових обмежень або вимог для систем ШІ цього рівня ризику.

До систем такого рівня може належати, наприклад, “Grammarly” – це онлайн-сервіс, який дозволяє користувачам перевіряти граматику та правопис своїх текстів. Програма використовує штучний інтелект для розпізнавання та виправлення помилок граматики, пунктуації, правопису та стилю письма.

Обмежений ризик: для систем ШІ обмеженого ризику встановлюються особливі зобов`язання щодо прозорості. Під час користування такими системами ШІ користувачі мають усвідомлювати, що вони взаємодіють з машиною, щоб мати можливість прийняти рішення: продовжувати чи припинити взаємодію.

Системи ШІ з обмеженим ризиком впливають на користувачів несуттєво. Зазвичай такі системи використовуються у сферах, де відбувається обмін даними або контентом між користувачами, наприклад, медійні платформи та соціальні мережі. Рекомендації на YouTube можна віднести до таких систем. YouTube використовує алгоритми для відбору та рекомендації відео користувачам, керуючись їхньою історією переглядів та інших параметрів. Це забезпечує більш персоналізований підбір контенту для користувачів без серйозного впливу на їхні права та свободи.

Високий ризик: До систем ШІ з високим ризиком належать ті, що мають значний вплив на права користувачів, їх здоров’я чи безпеку. Ці системи ШІ повинні відповідати переліку обов’язкових вимог та пройти процедури оцінки відповідності, перш ніж бути розміщеними на ринку ЄС. На постачальників і користувачів цих систем покладаються чіткі зобов’язання щодо безпеки.

Розділ, що регулює такі high-risk системи ШІ є одним із найбільших. В ньому визначається, що high-risk ШІ використовується в критичних сферах, таких як системи прийняття рішень у судових процесах, оцінки ризику в банківській сфері, контролю за працівниками, та біометричні системи ідентифікації. AI Aсt вимагає від розробників ШI систем високого ризику дотримуватися строгих вимог щодо безпеки, прозорості та етичності.

Системи цієї категорії поділяються на вісім основних груп, які:

- Використовують біометричну ідентифікацію;

- Застосовуються у критичній інфраструктурі (наприклад, транспорт), що може поставити під загрозу життя і здоров’я громадян;

- Визначають доступ до освіти або оцінюють студентів (наприклад, підрахунок балів на іспитах);

- Використовуються під час прийому на роботу, або приймають рішення щодо просування по службі, розірвання контрактів чи розподілу завдань (наприклад, програмне забезпечення для сортування резюме для процедур найму на роботу);

- Застосовуються під час надання приватних та державних послуг (наприклад, кредитний скоринг, який позбавляє громадян можливості отримати кредит);

- Використовуються в правоохоронних органах, які можуть втручатися у фундаментальні права людей (наприклад, оцінка достовірності доказів);

- Використовуються під час організації міграційних процесів, надання притулку або прикордонного контролю. Наприклад, застосування ШІ в поліграфах чи подібних інструментах для виявлення емоційного стану особи, перевірки автентичності проїзних документів;

- Допомагають у роботі судових систем та забезпечують різні демократичні процеси. Призначені для допомоги судовим органам у дослідженні фактів та законів, а також у застосуванні закону в різних ситуаціях.

Ці системи ШІ повинні будуть відповідати низці обов’язкових вимог та пройти процедури оцінки відповідності, перш ніж вони зможуть потрапити на ринок ЄС.

Для систем ШІ високого ризику, AI Act передбачає перелік конкретних вимог, таких як:

- чітке та адекватне інформування користувачів;

- застосування заходів людського нагляду для мінімізації ризиків порушення прав;

- реєстрація діяльності для забезпечення відстежуваності результатів;

- висока якість наборів даних, що живлять систему, для мінімізації ризиків та дискримінаційних результатів;

- детальна документація, що надає всю необхідну інформацію про систему та її призначення для органів влади, щоб вони могли оцінити її відповідність;

- забезпечення адекватних систем оцінки та пом’якшення ризиків;

- забезпечення високого рівня надійності, безпеки та точності.

Усі системи віддаленої біометричної ідентифікації відповідно до AI Act є високоризикованими та мають відповідати суворим вимогам. Використання віддаленої біометричної ідентифікації в публічно доступних місцях у правоохоронних цілях заборонено в принципі.

Проте є певні винятки, які в AI Act суворо визначені та регламентовані. Наприклад, якщо це необхідно для пошуку зниклої дитини, запобігання певної неминучої терористичної загрози чи виявлення злочинця.

Ці рівні ризику допомагають визначити, які системи ШІ потребують більшої уваги та регулювання з боку законодавця.

Заборонені системи ШІ: до них належать системи ШІ, які можуть стати джерелом загрози безпеці, життєдіяльності та правам людей, наприклад, застосування ШІ для переслідування уйгурів у Китаї. Такі системи заборонені незалежно від того, чи це система соціальної оцінки уряду чи іграшка з голосовою підтримкою, що заохочує небезпечну поведінку.

В AI Act особливо шкідливі практики ШІ заборонені як такі, що суперечать цінностям ЄС. До заборонених належать практики, які з високою ймовірністю можуть бути застосовані для маніпулювання людьми або використання вразливості окремих вразливих груп населення (діти, люди з обмеженими можливостями). Окрім цього, до таких практик відносять соціальне оцінювання державними органами на основі штучного інтелекту.

Органи регулювання

Відповідно до AI Act має бути створений орган EAIB (European Artificial Intelligence Board) та регулятори на національному рівні. EAIB складатиметься з представників держав-членів та Європейської комісії. Основним завданням такої комісії буде імплементація AI Act, а також збір та поширення найкращих практик серед держав-членів.

На національному рівні передбачається, що держави-члени призначатимуть один або декілька національних компетентних органів і серед них обиратимуть національний наглядовий орган. Основною метою такого національного органу має бути нагляд за застосуванням та імплементацією AІ Аct. Європейський інспектор із захисту даних діятиме як компетентний орган для нагляду за інституціями, установами та органами ЄС, які підпадають під дію AI Act.

Постмаркетинговий моніторинг, обмін інформацією, нагляд за ринком і контроль систем ШІ на ринку ЄС

Для систем ШІ високого ризику застосовується система постмаркетингового моніторингу. Вона повинна активно та систематично збирати, документувати та аналізувати дані, надані користувачами або отримані з інших джерел, щодо функціонування таких систем ШІ. Вона має базуватись на плані постмаркетингового моніторингу, який є частиною технічної документації відповідного продукту ШІ.

Такий моніторинг має відбуватись протягом усього їхнього життєвого циклу та дозволяти провайдеру оцінювати постійну відповідність систем ШІ вимогам викладеним в AIA. Детальніше про нього можна дізнатись в статті 61 AIA.

У випадку інцидентів або будь-яких несправностей в роботі ШІ має відбуватись обмін інформацією. Тому постачальники систем штучного інтелекту з високим рівнем ризику, представлених на ринку ЄС, повинні повідомляти органи ринкового нагляду держав-членів про будь-який серйозний інцидент або будь-який збій у роботі цих систем. Про такий збій варто повідомляти, якщо він є порушенням зобов’язань відповідно до законодавства ЄС, спрямованих на захист основних прав. Відповідне повідомлення скеровується до органів ринкового нагляду держав-членів, де стався цей інцидент або відбулося порушення.

Після отримання повідомлення, пов’язаного з таким порушенням, орган ринкового нагляду інформує національні державні органи чи інші органи, визначені A Act. Пiсля цього Комісія повинна розробити спеціальну інструкцію для сприяння дотриманню зобов’язань.

За ходом розвитку ринку систем ШІ здійснюється нагляд. Про результати такого нагляду національний наглядовий орган повинен регулярно звітувати Комісії. Звітування здійснюється з приводу інформації, яка може представляти потенційний інтерес для застосування права ЄС щодо правил конкуренції.

Кодекс поведінки

Комісія та держави-члени повинні заохочувати та сприяти складанню кодексів поведінки. Кодекси поведінки можуть бути складені окремими постачальниками систем штучного інтелекту або організаціями, які їх представляють, або обома, у тому числі із залученням користувачів і будь-яких зацікавлених сторін та організацій, що їх представляють. Кодекси поведінки можуть охоплювати одну або декілька систем штучного інтелекту залежно від цільового призначення відповідних систем.

Комісія та Правління мають брати до уваги інтереси та потреби розробників систем ШІ та заохочувати складати такі кодекси поведінки.

База даних ЄС для систем ШІ високого ризику

Перед розміщенням на ринку постачальники систем ШІ високого ризику зобов’язані зареєструвати їх у спеціальній базі даних. Така база має бути створена і управлятись Комісією. Комісія надає постачальникам таких систем ШІ технічну та адміністративну підтримку, а інформація, що міститься в базі даних ЄС, має бути доступною для громадськості.

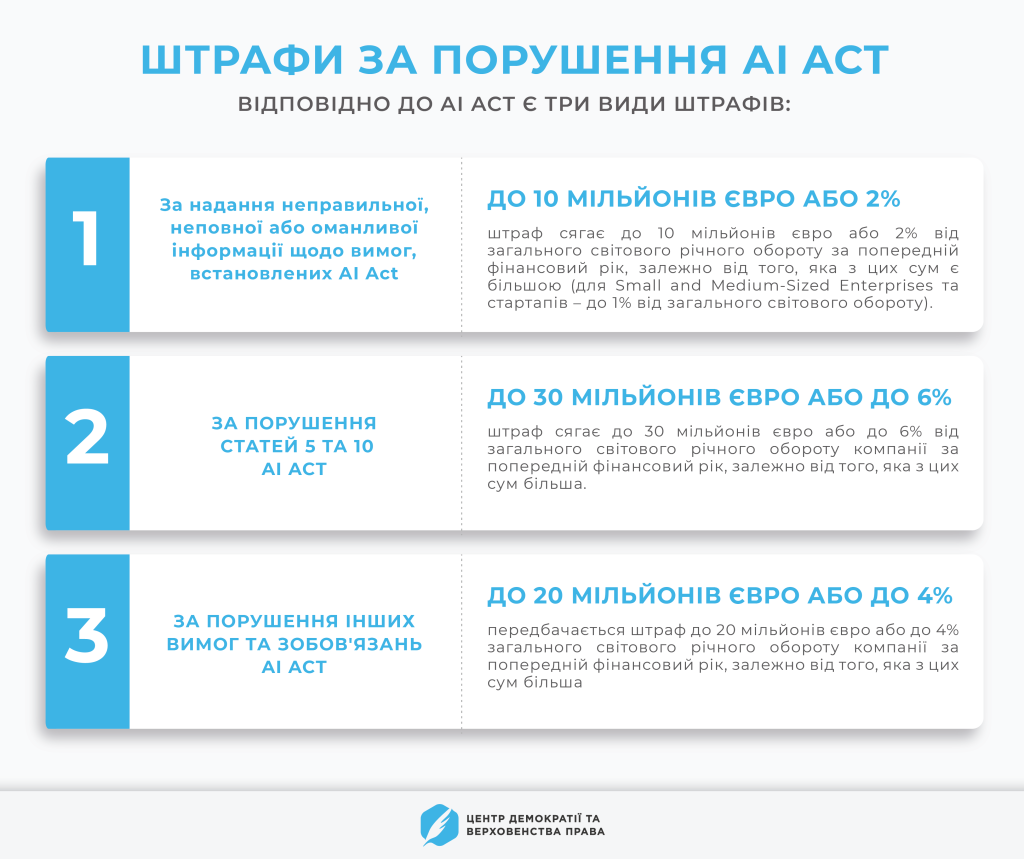

Штрафи за порушення Artificial Intelligence Act

AI Act передбачає встановлення штрафів за порушення законодавства, пов’язаного з використанням штучного інтелекту. Вони можуть сягати до 30 мільйонів євро або, якщо порушником є компанія, до 6% її загального світового річного обороту за попередній фінансовий рік, залежно від того, яка з цих сум є вищою та залежно від порушення.

Такі штрафи мають стимулювати розробників та постачальників систем ШІ дотримуватися вимог, що встановлює цей законопроект. Штрафи відрізняються залежно від типу порушення та рівня ризику системи ШІ. Розглянемо деякі приклади штрафів.

На органи ЄС, агенції та інституції відповідно до статті 72 AI Act можуть бути накладені адміністративні штрафи.

Під час прийняття рішення щодо розміру штрафу відповідно до AI Act враховуються обставини конкретної ситуації. Наприклад, тривалість порушення, характер та наслідки.

Регуляторні пісочниці

У розділі 5 AI Act йдеться про створення спеціальних регуляторних пісочниць. Концепція регуляторних пісочниць – один з інноваційних заходів, запропонованих AI Act і покликаних сприяти безпечному та ефективному впровадженню систем штучного інтелекту в практику.

Регуляторні пісочниці (далі – sandbox) – контрольоване середовище, в межах якого компанії-розробники ШІ зможуть від першої стадії розвивати свій продукт, враховуючи вимоги AI Act.

У червні 2022 року в Брюсселі у співробітництві з Єврокомісією та урядом Іспанії був представлений пілотний проєкт регуляторної пісочниці. Основним їхнім завданням є створення контрольованого простору для взаємодії розробників ШІ та регуляторів.

23 березня 2023 року під час організованого Центром демократії та верховенства права форуму “Штучний інтелект 2.0: регулювання та робота під час війни”, Гордій Румянцев, державний експерт Директорату європейської та євроатлантичної інтеграції у Міністерстві цифрової трансформації України, повідомив, що така регуляторна “пісочниця” буде запущена в Україні:

“Якщо ми оптимістично дивимось на наші перспективи щодо набуття повноцінного членства в Європейському Союзі, то дія акту (AI Act – прим. ред.) буде автоматично розповсюджена на Україну. Тому ми рухаємось в цьому напрямку з розумінням того, що рано чи пізно ми наблизимось до імплементації акту (AI Act – прим. ред.).

Ще однією важливою річчю є екстериторіальна дія акту… Фактично, будь-яка компанія незалежно від того, де вона інкорпорована, якщо вона просуває свій продукт чи сервіс на ринок ЄС, повинна відповідати вимогам майбутнього акту.

Тобто, якщо українська компанія розробляє певний продукт всередині країни, а потім має мету вийти на ринок ЄС, то недостатньо буде відповідати вимогам лише українського законодавства, а необхідно враховувати вимоги і норми Європейського акту (AI Act – прим. ред.).

Ми могли б розглянути можливість прийняття альтернативного більш ліберального для бізнесу закону, але це все залишалося б внутрішньою історією… Це б створило тепличні умови для компаній всередині країни і вони не те, що були б не конкурентноздатними, а не могли б навіть отримати доступ до європейського ринку.

Я дуже радий анонсувати, що ми починаємо використовувати такий інструмент як регуляторний sandbox, або регуляторна “пісочниця”. В нашому розумінні регуляторний sandbox зі штучного інтелекту є середовищем, в рамках якого компанії розробники можуть від початкової стадії (дизайну) розробляти свій продукт так, щоб він враховував вимоги майбутнього акту європейского союзу (AI Act – прим. ред.). Тобто компанія стає учасником такого sandbox, вона отримує експертну оцінку на всіх етапах розробки свого продукту для того, щоб потім мати можливість вийти на ринки Європейського Союзу”.

Пан Румянцев додав, що участь у sandbox не є обов’язковою, а компанії можуть долучитися до них на власний розсуд.

Джерело: Скріншот з прямої трансляції у Facebook

Висновки

Штучний інтелект став невід’ємною частиною усіх сфер нашого життя від медицини до розважальних ігор. Тому ініціювання Європейською комісією прийняття AI Act є необхідним кроком для того, щоб запобігти безлічі порушень прав людини через використання ШІ.

Акт передбачає встановлення системи аудиту та незалежної оцінки впливу штучного інтелекту на права та свободи людини. Це допоможе забезпечити вищий рівень захисту прав людини в контексті використання штучного інтелекту.

Країни вже зараз повинні враховувати норми AI Act, щоб бути конкурентоспроможними. Дотримання вимог AI Act може відчутно змінити ринок штучного інтелекту в ЄС та посприяти створенню безпечнішого та етичнішого середовища для розвитку ШІ.

В контексті цього виділимо такі важливі кроки для тих, хто займається розробкою та розвитком систем ШІ:

- Враховувати ризики. Розробникам ШІ варто проаналізувати, до якого рівня ризику потенційно буде належати їхня програма ШІ. Це допоможе надалі краще зрозуміти вимоги, які з часом будуть застосовувані до такого ШІ.

- Проявити ініціативу щодо участі в регуляторній “пісочниці”. Рекомендуємо одразу починати планувати створення свого продукту чи його розвиток з урахуванням таких вимог, що допоможе не опинитись “за бортом корабля”, коли AI Act набуде чинності.

Зі свого боку Україні як державі варто звернути увагу на наступні необхідні кроки:

- Ретельно дослідити особливості та основні вимоги AI Act для підготовки до імплементації акту.

- Розпочати роботу із розробки та запровадження законодавчого закріплення роботи регуляторних пісочниць з ШІ.

- Організувати роботу експертних груп спеціалістів у сфері штучного інтелекту та законотворення, які визначать основні сфери правового регулювання ШІ та підготують відповідні законопроєкти.

Визначення регуляторного органу у сфері штучного інтелекту з основною функцією контролю за дотриманням законодавства саме у цій сфері.