Коли Роберт Оппенгеймер розповідав про враження, після вихубу першої ядерної бомби в історії людства, він процитував слова з індуїстського священного писання “Бгаґавад-Ґіти”: “Я став смертю, руйнівником світів”. Цей момент став символом двозначності наукового прогресу: з одного боку, можливість вирішення глобальних проблем, з іншого — потенційна загроза незворотних катастроф.

Сьогодні ми знову стоїмо на порозі подібного моменту, але вже в контексті розвитку штучного інтелекту (ШІ). Як і ядерна енергія, ШІ має потенціал стати інструментом для добра або зла. Те, як він використовується, залежить лише від людей і зараз ми вже можемо сміливо казати, що ризики використання ШІ не примарні. Уявіть світ, де реальність і вигадка можуть бути так переплетені, що розрізнити їх стає майже неможливо. Світ, де кожне слово, кожне зображення може бути маніпульованим. Де фейки, які раніше потрібно було розробляти протягом тривалого часу, генеруються за лічені хвилини. Це не сюжет наукової фантастики, а все більша частина нашої реальності.

Світ постійно має справу з таким викликом, як дезінформація, яка створюється за допомогою штучного інтелекту. І ризики значні: підрив довіри до авторитетних джерел, маніпулювання громадською думкою та суспільними настроями, втручання у виборчі процеси тощо. Аби зрозуміти, які виклики, пов’язані з використанням штучного інтелекту (ШІ), стоять перед нами, Центр демократії та верховенства права проаналізував інструменти, за допомогою яких створюється дезінформація з використанням штучного інтелекту (відео/ аудіо/ фото- діпфейк, дезінформаційні тексти), ризики ШІ у формуванні дезінформації та способи їх подолання. Та, що не менш важливо, розглянемо випадки, коли використання цих технологій може полегшити наше життя, а не лише завдати шкоду.

Імітація зображення людини та її голосу

Що ж таке deepfake? Поняття deepfake складається з двох частин: “deep learning” (глибинне навчання) та “fake” (підробка). Це фото, відео чи аудіо, що створюється за допомогою алгоритмів машинного навчання, і повністю відтворює зображення чи відеозображення людини. Фактично створює фейковий матеріал.

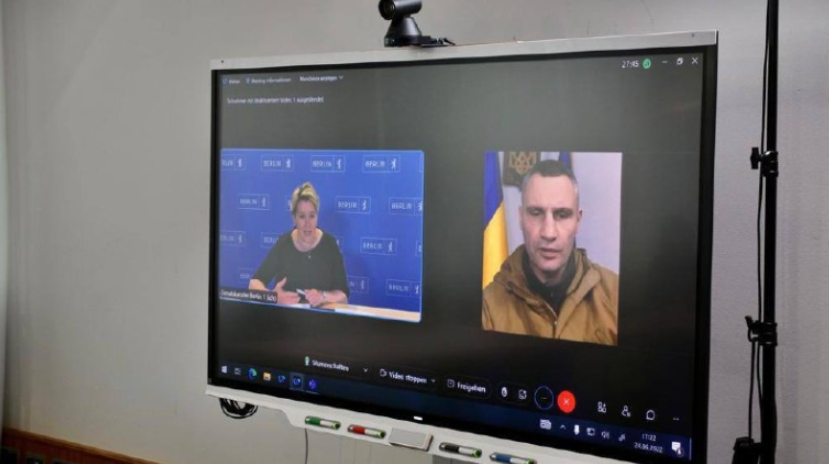

Нам може здаватись, що для того, аби ввести когось в оману за допомогою діпфейку, потрібно згенерувати неймовірної якості відео, але ні. Показовою є ситуація, коли мери Берліна, Відня, Мадрида, Будапешта та Варшави провели дзвінок зі згенерованою версією Віталія Кличка. Зловмисники створили віртуальний двійник мера Києва за допомогою технології deepfake, а перед цим самостійно домовились про дзвінок. Мер Берліна Франциска Ґіффай в ході розмови відключилась, бо через дивні прохання мера запідозрила, що з ним щось не так. А от Міхаель Людвіг бургомістр австрійської столиці не зрозумів, що з ним вів розмову не справжній Кличко, і після розмови написав про неї у соцмережах.

Джерело світлини: канцелярія мерії Берліна

У США жінку з Пенсильванії Рафаеллу Марі Споне звинуватили у використанні технології діпфейк для переслідування черлідерів аби вигнати суперниць доньки з команди підтримки. Вона розсилала зображення та відео, які були створені за допомогою цієї технології дівчатам з групи підтримки, їхнім батькам та власникам спортзалу. На таких діпфейках підлітки були зображені оголеними, такими, що вживають алкоголь або палять електронні сигарети. Для цього жінка використовувала кілька підроблених телефонних номерів. Офіцери врешті-решт зайшли до будинку жінки з ордером на обшук і відстежили повідомлення за IP-адресою та мобільним телефоном обвинуваченої. Після аналізу відео та фотографій, було встановлено, що вони були діпфейками. Їх зробилии шляхом нанесення фотографій дівчат, розміщених у їхніх соціальних мережах, на інші зображення.

Ці інциденти викликають серйозні питання щодо безпеки та можливості використання ШІ з маніпулятивною метою. Але це ще не все. Інструменти штучного інтелекту можуть досить професійно проводити маніпуляції зі звуком. Такі технології як “Respeecher” або “Descript” можуть імітувати голос конкретної особи, створюючи аудіозаписи, які звучать, наче вони були сказані реальною людиною. Прикладом правдоподібного імітування голосу та відео є відоме відео, де начебто Барак Обама розповідає про небезпеку фейкових новин та дезінформації. Насправді це діпфейк, який створив режисер Джордан Піл.

Якщо випадок з Бараком Обамою не видається небезпечним, приклад, який ми наведемо далі змушує небезпідставно побоюватися стрімкого розвитку новітніх технологій. Нещодавно відомим став новий спосіб шахрайства, коли зловмисники використовують штучний інтелект для імітації голосів людей. За допомогою технологій ШІ шахраї створюють дуже переконливі аудіозаписи, які імітують голос конкретної особи. Вони досить активно використовують цю технологію аби обдурювати людей, наприклад, змусити їх переказати гроші або надати конфіденційну інформацію. Тому важливо завжди перевіряти достовірність інформації перед тим, як здійснювати певні дії після таких телефонних дзвінків чи повідомлень.

Ці приклади підкреслюють важливість навичок вирізняти неправдиву інформацію та перевіряти джерела інформації в сучасному світі, де технології штучного інтелекту стають все більш доступними, та останнє, але не менш важливе — напрацьовувати, як на державному, так і на бізнес рівнях, інструменти протидії дезінформації, яка, зокрема, створюється за допомогою ШІ.

Проте є і позитивний бік використання діпфейків. Наприклад, розробка USC Shoah Foundation “Dimensions in Testimony” дозволяє людям задавати питання та отримувати відповіді в реальному часі від попередньо записаних відеоінтерв’ю з тими, хто вижив у Голокості та іншими свідками геноциду. Це стало можливим завдяки застосуванню технологій, які застосовуються для створення діпфейків, наприклад обробки природної мови. Таким чином відвідувачі музею, отримують особливий досвід вивчення історії попередніх поколінь зовсім новим способом взаємодії.

Джерело: USC Shoah Foundation

Генерування тексту з ноткою дезінформації та загрози демократії

ChatGPT може швидко створювати переконливий текст на будь-яку тему. Це може бути легко використано для створення фейкових новин, вигаданих історій або навіть наукових досліджень. Ми вже писали про те, що з ChatGPT потрібно поводитися обережно та перевіряти наративи, які він поширює, як наприклад про те, що Крим — це спірна територія.

Про необхідність усвідомлення всіх потенційних ризиків ШІ і як легко він може стати причиною дезінформації з приводу важливих, зокрема і геополітичних тем, свідчить випадок, коли українські медіа опублікували новину про те, що Сербія придбала 20 000 Shahed-136, які начебто замовила в Ірану. Як виявилось пізніше інформація була фейковою, а згенерував її штучний інтелект. Новина про купівлю дронів була поширена на акаунті Х (Twitter). На цій сторінці всі новини генерує штучний інтелект. Цікавим є те, що частково новина була правдивою, оскільки 7 серпня Горан Алексич, заступник міністра закордонних справ Сербії, дійсно відвідував Іран. Проте, інформацію про купівлю дронів придумав ШІ.

Дезінформація змінює довіру людей до медіа та підриває авторитет. Основною метою дезінформації є руйнування довіри до правдивої інформації. Вченими Массачусетського технологічного інституту в ході дослідження було встановлено, що твіти з дезінформацією поширюються людьми набагато швидше, ніж правдиві. Таким чином ця загроза є ще більшою.

Про це каже Сінан Арал професор Школи менеджменту MIT Sloan: “Ми виявили, що неправда поширюється значно далі, швидше, глибше та ширше, ніж правда, у всіх категоріях інформації, і в багатьох випадках”.

Дослідники звернули увагу саме на факт того, що неправдива інформація в X (Twitter) поширюється настільки швидко зовсім не через спеціальних ботів, а внаслідок репостів звичайних користувачів. Тобто проблема полягає не лише в тому, що системи ШІ допомагають надзвичайно швидко згенерувати матеріали, що містять дезінформацію, а в тому, що у більшості людей недостатній рівень фільтрування того, чому вони вірять.

Вчені підкреслюють, що, враховуючи це, надзвичайно важливим є визначення способів, які можуть допомогти обмежити дезінформацію. І одразу додають, що, якби це були лише боти, їм потрібно було б технологічне рішення.

Показовим прикладом того, як дезінформація, внаслідок використання штучного інтелекту може потенційно загрожувати демократії є випадок у Великій Британії. У серпні 2021 року внаслідок кібератаки зловмисники отримали доступ до даних 40 мільйонів виборців Великої Британії. Цей витік даних залишався непоміченим протягом цілого року. Лише в жовтні 2022 року було виявлено, що трапилась подібна атака, а громадськість повідомили про цю ситуацію аж через 12 місяців. В базі даних зберігались імена та адреси всіх виборців, зареєстрованих у період з 2014 по 2022 рік.

Представники виборчої комісії заявили, що вони не можуть достеменно знати, до якої саме інформації зловмисники отримали доступ, та чи не були вони пов’язані з ворожою державою, такою як росія.

Зараз експерти попереджають, що ці дані можуть бути використані для дезінформації виборців за допомогою штучного інтелекту, який може допомогти у швидкому генеруванні неправдивої інформації.

Британський наглядовий орган за виборами заявив, що цілісність британської виборчої системи не знаходиться під загрозою, оскільки вона здебільшого базується на паперових носіях. Проте ці дані все ще можуть бути використані зловмисниками, якщо вони будуть розгорнуті разом з новими потужними інструментами штучного інтелекту. Зараз та у наступні роки процес виборів може зіштовхнутись з великою кількістю перепон внаслідок використання систем штучного інтелекту. На відміну від попередніх років, коли інструменти ШІ ще не були настільки популярні серед людей, а швидкість генерування фейкового контенту була не такою високою, зараз генерувати дезінформаційні матеріали набагато простіше, а відповідно виклики щодо виявлення та подолання цих явищ збільшились.

Звісно, що ШІ не можна вважати тотальним злом — це лише інструмент, який почали використовувати для досягнення негативних цілей, тоді як ШІ першопочатково створювали з метою спростити та пришвидшити процеси людської діяльності. Так, ШІ використовується і з метою протидії дезінформації та тотожних явищ. Наприклад, ШІ є помічником Центру стратегічних комунікацій, де його використовують для моніторингу медіа-простору та аналізу онлайн публікацій. За допомогою автоматизованих засобів глибокого аналізу виявляють певні інформаційні тренди, відслідковують зміни реагування користувачів соціальних мереж на інформаційні тренди, виявляють мову ненависті.

Як розпізнати штучний інтелект

Для того, щоб зрозуміти, що контент створено ШІ, можна використовувати той самий ШІ, а також звернути увагу на аспекти, які менш притаманні живій людині та більш притаманні згенерованому матеріалу. Так, про те, що голос був згенерований ШІ свідчить:

- Монотонність: ШІ-голоси можуть звучати монотонно або без емоцій.

- Нестандартна інтонація: іноді ШІ може неправильно ставити наголос у словах або робити паузи в невластивих місцях.

Для перевірки, чи не був голос згенерованим, можна використати Descript’s Overdub.

Про “штучність” відео свідчитиме:

- Невідповідності в анімації: обличчя або рухи можуть виглядати дещо незвично або неприродно, розсинхронізовано.

- Артефакти на відео: можуть з’являтися дивні предмети на фоні.

Щоб перевірити, чи було відео згенероване ШІ, можна використати Deepware Scanner.

Також для перевірки контенту можна використати Truly Media – платформа, що містить функції на основі ШІ для перевірки цифрового контенту та виявлення дезінформації.

Побороти дезінформацію, відбілити ШІ

Міжнародні тренди

Раніше ми вже розглядали питання того, як у ЄС планують регулювати штучний інтелект. Також ще у 2020 році світ побачив Європейську цифрову стратегію (Europe’s Digital Decade). Складається вона з основних 4 напрямків:

- цифрові навички;

- цифрова трансформація бізнесу;

- безпечна та стійка цифрова інфраструктура;

- цифровізація державних послуг.

Стратегія передбачає, що до 2030 року 80% європейських громадян повинні володіти принаймні базовим рівнем цифрових навичок. Базові навички означають здатність виконувати за допомогою цифрових засобів принаймні одну діяльність. Така діяльність може бути пов’язана з такими сферами: інформаційна, спілкування та співпраця, створення контенту, безпека та особисті дані, а також вирішення проблем. Це буде відбуватись завдяки структурованому діалогу з державами-членами з питань цифрової освіти та навичок, розробки спільних рекомендацій Європейською Комісією для вчителів та освітян з метою сприяння розвитку цифрової грамотності та розпізнавання дезінформації через освіту та навчання, розробки етичних настанов з використання ШІ та даних у навчанні та викладанні для освітян та введення Європейського сертифіката цифрових навичок.

З точки зору дезінформації існує важливий законодавчий акт – Digital Services Act (DSA). Головний принцип якого звучить так: “що незаконно в офлайні, те має бути незаконним і в онлайні”. Тобто правила, які діють в офлайні, мають також застосовуватися в онлайн-просторі. Цей акт демонструє намір ЄС створити більш безпечний цифровий простір, в якому захищені основні права всіх користувачів цифрових послуг. Однією з причин розробки такого акту було те, що онлайн-сервіси зловживають маніпулятивними алгоритмічними системами для посилення поширення дезінформації та для інших шкідливих цілей.

DSA застосовується безпосередньо в ЄС і набув чинності 25 серпня 2023 року. Однією з його цілей є зменшення системних ризиків та дезінформації. Однією з ключових особливостей DSA є модерація контенту. В акті зазначено, що “постачальники повинні приділяти особливу увагу тому, як їхні послуги використовуються для поширення або розширення оманливого вмісту, включаючи дезінформацію”. Відповідно до нього кожна онлайн-платформа повинна мати функціонал, який дозволить користувачам позначати протиправний контент і сповіщати про такий контент онлайн-платформу.

Також він містить вимоги до прозорості алгоритмів, наприклад, блокування має бути здійснене з використанням прозорих алгоритмів, а натомість користувачам забезпечується можливість судового оскарження таких дій. Це у свою чергу зменшить можливість маніпулювання користувачами та їхніми діями в мережі. А, як результат, зменшить дезінформаційні кампанії, в яких використовують ШІ для досягнення своїх цілей, оскільки така діяльність буде більш контрольованою.

Тим часом уряд Британії додав штучний інтелект до списку загроз в “Національному реєстрі ризиків”. Згідно з опублікованим реєстром ризиків 2023 року штучний інтелект вперше було офіційно визнано ризиком. Уряд Британії наголосив на тому, що розвиток систем штучного інтелекту та їхніх можливостей має низку наслідків що охоплюють хронічні та гострі ризики. І як один з таких наслідків вони наводять збільшення дезінформації при неналежному поводженні з системами ШІ, а також зниження економічної конкурентоспроможності. Уряд Великої Британії зобов’язався провести перший глобальний саміт щодо безпеки ШІ, який об’єднає провідні країни, технологічні компанії та дослідників, щоб узгодити заходи безпеки для оцінки та моніторингу ризиків, пов’язаних зі штучним інтелектом.

ЦЕДЕМ вже писав про те, як в США пропонують врегулювати ШІ. У 2021 році розроблено Національну стратегію США зі штучного інтелекту, яка не має зобов’язального характеру. В ній йдеться про необхідність підтримки міжнародної співпраці зі стратегічними союзниками щодо досліджень і розробок систем ШІ, залучення інвестицій до розвитку ШІ та інше. А у жовтні 2022 року Управління наукової та технологічної політики Білого дому опублікувало законопроєкт про права у сфері штучного інтелекту (Blueprint for an AI Bill of Rights), в якому викладені принципи, що повинні захистити суспільство від негативного використання ШІ. В ньому визначили 5 основних принципів, якими мають керуватись розробники ШІ:

- Безпечні та ефективні системи. Акцент на необхідності розробки безпечних та ефективних технологій. Принцип передбачає консультації з експертами та зацікавленими сторонами, тестування систем перед запуском і постійну оцінку їх безпеки.

- Алгоритмічний захист від дискримінації. Цей принцип зосереджується на недопущенні дискримінації в ШІ. Він передбачає, що алгоритми мають бути навчені на різноманітних даних і проходили тестування щодо наявності дискримінації.

- Конфіденційність даних. Відповідно до цього принципу персональні дані користувачів мають бути захищені, а розробники повинні надавати інструменти для управління даними, включаючи збір, доступ та видалення.

- Пояснення цілей використання. Цей принцип означає те, що користувачі повинні знати, як і для чого використовується ШІ. Розробники мають надавати зрозумілу документацію та пояснення.

- Людські альтернативи та запасні варіанти. Цей принцип окреслює необхідність наявності людських альтернатив для тих, хто не хоче користуватися автоматизованими системами. Він також акцентує на важливості запасних варіантів на випадок збоїв.

Цікаво, що каліфорнійці прагнуть першими врегулювати питання, що пов’язані з ШІ, та вже представили свій законопроєкт № 331. Він містить пропозицію внести зміни до Business and Professions Code та реалізувати принципи, що закріплені в законопроєкті про права у сфері штучного інтелекту. Законопроект Каліфорнії передбачає необхідність повідомляти людину, якщо в певному процесі щодо неї ухвалюють рішення із застосуванням ШІ. Також людина має знати опис інструменту, контактну інформацію розпорядника інструменту. Наразі загальнофедерального нормативного регулювання в США немає.

Вище в аналітиці ми вже говорили про те, як маніпуляції поведінкою людей можуть стати загрозою демократичним виборам. Саме це стало одним із ризиків, який викоремили після того, як генеральний директор OpenAI Сем Альтман 16 травня закликав Конгрес США до регулювання штучного інтелекту. Іншими загрозами, які зазначив сенатор Джош Хоулі стали масова втрата робочих місць та порушення права на недоторканність приватного життя.

Ще у 2019 році Техас, Каліфорнія, Вірджинія стали першими штатами, які прийняли законодавство про діпфейки. Переважна частина цих законів регулюють діпфейки в контексті порнографії та впливу на вибори.

1 вересня 2019 року у Техасі прийняли закон, що забороняє створення та розповсюдження діпфейків, які спрямовані на заподіяння шкоди кандидатам на державні посади або вплив на вибори. У законі зазначається, що правопорушенням є те, якщо особа з метою вплинути на результат виборів чи завдати шкоди кандидату створює діпфейк відео або публікує чи розповсюджує діпфейк відео протягом 30 днів після виборів.

А 1 вересня 2023 року Техас прийняв другий законопроект для боротьби з діпфейками вже сексуального характеру.

Наприклад, цей закон містить положення, що особа вчиняє правопорушення, якщо без фактичної згоди особи, яка виглядає зображеною, особа свідомо створює або розповсюджує за допомогою електронних засобів фейкове відео, яке, здається, зображує особу з відкритими інтимними частинами або залученими до сексуальної поведінки.

І перший і другий закон визначають “діпфейк” як відео, створене за допомогою штучного інтелекту, що імітує зображення реальної людини для введення в оману.

Влітку 2023 року в Мінесоті прийняли закон, що забороняє розповсюдження діпфейків для впливу на вибори або розповсюдження порнографії без згоди. Діпфейки в законі визначаються як зображення чи відео, які є настільки реалістичними, що розумна людина повірить, що вони зображують мову чи поведінку особи. У випадку, якщо особа здійснювала вплив на вибори, їй може загрожувати штраф у розмірі 1000 доларів США та/або покарання до 90 днів, за умови, що злочинець не мав наміру спричинити насильство чи тілесні ушкодження або не був засуджений за аналогічний злочин протягом п’яти років.

У Сінгапурі діє Закон про захист від брехні та маніпуляцій в інтернеті (Protection from Online Falsehoods and Manipulation Act – POFMA), що прийняли 8 травня 2019 року. Його основна мета:

- запобігання повідомленню неправдивих заяв про факти в Сінгапурі та дозвіл вжиття заходів для протидії наслідкам такого повідомлення;

- виявлення, контроль та захист від скоординованої неавтентичної поведінки та інших зловживань онлайн-акаунтами та ботами;

- припинення фінансування, просування та іншої підтримки онлайн-платформ, які неодноразово повідомляють неправдиві заяви про факти в Сінгапурі;

- дозвіл вжиття заходів для покращення розкриття інформації щодо платного контенту, спрямованого на політичну мету.

Відповідно до POFMA будь-який міністр може видати вказівку щодо обмеження облікових записів і таким чином змусити інтернет-посередника закрити будь-які підроблені облікові записи чи ботів на своїх платформах. Якщо особа свідомо поширює неправдиві відомості в Інтернеті за допомогою фейкового облікового запису або бота, вона може бути оштрафована на суму до 100 000 сінгапурських доларів і/або позбавлена волі на строк до 10 років.

Українські тренди

У 2020 році затверджено Концепцію розвитку штучного інтелекту в Україні. В ній зазначено про необхідність доопрацювати питання щодо регулювання суспільних відносин у сфері розвитку ШІ. А нещодавно відновив свою роботу комітет з питань розвитку сфери штучного інтелекту в Україні при Міністерстві цифрової трансформації, який, зокрема, працює над розвитком законодавчої бази регулювання ШІ. Звісно, під час напрацювання регулювання буде взято до уваги і питання створення та поширення дезінформації за допомогою ШІ. Зараз представники комітету також вважають за потрібне врахувати досвід Великої Британії, яка видала White Paper щодо ШІ та який описує підхід уряду до збалансування регулювання та стимулювання ШІ, а також дає краще розуміння для суспільства і бізнесу вектору розвитку ШІ.

В Україні питання розвитку ШІ обговорюються досить активно. Зокрема ЦЕДЕМ проводить щорічний форум на тему ШІ для обговорення актуальних питань розвитку штучного інтелекту та особливостей світових тенденцій його правового регулювання. Запрошені українські та міжнародні експерти діляться останніми напрацюваннями та нововведеннями у сфері ШІ.

Нещодавно на такому Форумі спікерка Деніз Вагнер, радниця офісу представника ОБСЄ з питань свободи медіа, звернула увагу, що засоби штучного інтелекту, а особливо системи рекомендацій та таргетована реклама – основні засоби, які дозволяють розповсюджувати дезінформацію онлайн. Та додала, що “одна із сфер, на які варто звернути увагу з точки зору регулювання, це розповсюдження та техніки розповсюдження дезінформації. Певний контент потрібно обмежувати або видаляти. Багато країн впроваджують антидезінформаційні закони, однак вони мають дуже широкі формулювання і дуже часто це перетворюється в цензуру. Таку цензуру, яка обмежує навіть професійні етичні журналіські роботи. Що стосується регулювання. Регуляторна ситуація, що стосується діпфейків чи дезінформації, а також інших проблем з інформацією – це складна мережа конституційних норм. Є жорсткі та м’які регулювання на міжнародному рівні та рівні держав. Щодо діпфейків. Регуляторна система має залучати усі сторони, що залучені до життєвого циклу такого матеріалу. Наприклад діпфейку. Потрібно враховувати права того, хто його створив; особи, яка там зображена; власника авторських прав; розробника технології; платформу посередника, яка використовується для розповсюдження, а також користувачів платформи, які його завантажили, скопіювали та поділились. Наразі не існує єдиної формули щодо зупинки розповсюдження дезінформації”.

Вона підкреслила, що зараз важливою є не лише свобода слова, а й свобода бути вільним від дезінформації. З чим складно не погодитись, враховуючи кількість контенту, що зараз генерується і потрапляє до нашого інфопростору.

Тренди бізнесу

OpenAI, один з лідерів у сфері ШІ, не залишає це питання без уваги. 26 липня 2023 року OpenAI разом із такими технологічними гігантами, як Google, Microsoft та Anthropic, оголосили про створення “Frontier Model Forum” — органу, що спрямований на сприяння безпечному та відповідальному розвитку передових моделей ШI. Його мета – сприяти дослідженню безпеки ШI, визначати найкращі практики безпеки, ділитися знаннями з політиками, академічними співтовариствами та іншими зацікавленими сторонами.

“Frontier Model Forum” також сприятиме вирішенню проблеми того, щоб ШI служив людству, а не шкодив йому, порушуючи права людей. Його основні завдання включають дослідження безпеки ШI, визначення найкращих практик для розвитку та впровадження передових моделей, співпрацю з політиками та академічними співтовариствами, а також розробку застосувань, які допоможуть вирішити найбільші проблеми суспільства, тобто питань функціонування безпечного ШІ.

Зараз його засновники вже планують створити консультативний орган для визначення своєї стратегії та пріоритетів. Вони також збираються співпрацювати з урядами та громадськістю для того, щоб розробити ефективні механізми співпраці.

Цей крок OpenAI та їх партнерів є важливим моментом у розвитку штучного інтелекту. Він показує, що великі гравці у сфері ШI розуміють свою відповідальність перед суспільством і готові працювати разом, щоб створювати безпечне майбутнє для всіх нас.

На щастя, світові компанії та уряди не стоять осторонь та намагаються боротись з дезінформацією. Наприклад, Facebook вже використовує алгоритми для виявлення та блокування “Deepfake” відео.

Ще одним прикладом такої боротьби є зобов’язання, яке взяли на себе великі компанії такі як Amazon, Anthropic, Google, Inflection, Meta, Microsoft і OpenAI позначати контент згенерований їхніми системами водяними знаками.

Висновки

Враховуючи зростаючу роль штучного інтелекту в сучасному світі, особливо в контексті генерації контенту, нам варто бути особливо обережними щодо ризику дезінформації. Штучний інтелект може створювати переконливі текстові, аудіо та візуальні матеріали, які можуть вводити в оману навіть найбільш досвідчених споживачів контенту.

Саме тому рекомендуємо

Споживачам інформації:

- Займатися самоосвітою: проходьте онлайн курси щодо виявлення та протидії дезінформації, а також відслідковуйте, які оновлення з’явились у сфері ШІ. Розуміння того, як працює ШI, може допомогти вам краще розпізнавати його ймовірні результати роботи. Наприклад, курс про ШІ від Дія.Освіта.

- Розвивати критичне мислення: уважно споживайте контент, завжди перевіряйте джерела інформації та не довіряйте навіть найбільш авторитетним джерелам без додаткової перевірки.

- Використовувати інструменти перевірки: існує багато інструментів та платформ, які допомагають визначати контент, створений за допомогою штучного інтелекту. Використовуйте їх для перевірки підозрілого контенту.

- Звертати увагу на деталі: штучний інтелект, хоча і досить потужний, все ж таки може залишати “цифрові сліди” у своєму контенті. Наприклад, деякі невідповідності в тексті або незвичайні артефакти на зображеннях.

- Проводити консультації з експертами: якщо ви сумніваєтеся в достовірності інформації, згенерованої ШІ, звертайтеся до експертів у відповідній галузі для консультації. Такі консультації надають експерти Центру демократії та верховенства права. Для того, щоб їх отримати, зверніться з вашим запитом на пошту: info@cedem.org.ua

- Бути обережними з соціальними мережами: багато дезінформації поширюється саме через них. Перевіряйте інформацію та намагайтеся не ділитися неперевіреною інформацією.

Державі:

- Розробити та опублікувати Білу книгу, в якій буде описано, чого варто очікувати бізнесу та суспільству найближчим часом, висвітлено підходи держави до регулювання ШІ та описано кінцеві результати, які держава планує досягнути.

- Публікувати рекомендації щодо використання інструментів ШІ громадянським суспільством та бізнесом.

- Враховувати євроінтеграційні прагнення України при визначенні шляху правового регулювання штучного інтелекту з урахуванням ризиків створення дезінформації за допомогою ШІ.

- Створювати та пропагувати серед населення освітні матеріали щодо розпізнавання та боротьби з дезінформацією, яка створюється й поширюється за допомогою ШІ.

Розробляти законодавство щодо регулювання та розвитку ШІ. Останнім, але не менш важливим аспектом є визначення впливу дезінформації, породженої ШІ, яка негативно впливає на суспільство, зокрема, створює панічні настрої серед населення, зневіру, особливо в умовах війни тощо. Відтак, боротьба проти дезінформації, виготовленої з використанням ШІ, а також врегулювання створення та розвитку ШІ є одними з головних стратегічних завдань держави. Розробка та прийняття відповідного законодавства, яке регулюватиме створення та використання ШІ в Україні, а також поширення дезінформації за його допомогою разом із просвітою населення у сферах дезінформації та штучного інтелекту будуть дієвим комплексним підходом, що гарантуватиме гармонійний розвиток суспільства в епоху ШІ. Окрім того, він стане ключовим фактором у забезпеченні стійкості та резилієнтності суспільства перед викликами, пов’язаними з впливом дезінформації, створеної за допомогою штучного інтелекту.