Матеріал опубліковано у виданні “Детектор медіа”

Згідно з даними ITU, станом на 2020 рік 66% населення Землі користується інтернетом. З цієї кількості в середньому 70-80% використовує його задля соціальних мереж. Більше того, суттєва частина трафіку припадає на країни Африки, Азії та Латинської Америки – частини світу, також відомої як «Глобальний Південь». Як і в решті світу, серед країн Глобального Півдня Facebook має неабияку популярність. Наприклад, кількість користувачів у Африці, за оцінками Statista, становить близько 250 млн. Користувачів з Азійсько-Тихоокеанського регіону, одного з найбільш динамічних ринків, – близько 1.2 млрд. Близькосхідних користувачів, за різними оцінками, – близько 70 млн. Латиноамериканські країни збільшують цю кількість людей ще на декілька сотень мільйонів. Загалом, аудиторія Facebook не зі США та Канади становить 90% користувачів платформи.

Що об’єднує Україну та країни Глобального Півдня, якщо йдеться про Facebook? Некоректна модерація контенту, який стосується політичної чи військової тематики, що призводить або до невиправданого видалення публікацій, або навпаки до того, що контент залишається на платформі навіть попри його проблематичність у вигляді порушень Стандартів спільноти Facebook. Більше того, другий сценарій часто створює умови для поширення шкідливих меседжів усередині певної країни: це може бути як відносно «легкий» варіант у вигляді дезінформації, так і більш важкі випадки на кшталт пропагування ненависті відносно етнічних чи релігійних спільнот або прямих закликів до вбивств. Мільярди юзерів Facebook із цих країн стикаються з різними викликами політичного характеру: антиурядові протести у Колумбії в 2021 році, війна в Ефіопії 2020-2022 років, військова хунта у М’янмі, розпалювання релігійної ворожнечі в Індії – це лише декілька прикладів ситуацій, в контексті яких рішення Facebook могли прямо впливати на безпеку людей. Детальніше про модерацію контенту в країнах Глобального Півдня читайте в аналітиці Центру демократії та верховенства права.

В’їзд до кампусу Meta (Minette Lontsie, Wikimedia Commons)

Антологія проблеми модерації

Як приймаються рішення про видалення контенту чи його збереження завдяки алгоритмам Facebook? У цьому питанні варто звернутися до двох речей: динаміки відносин як всередині центрального офісу Meta, так і зі сторонніми організаціями, та інвестиції в модерацію контенту.

Динаміка відносин. Велика частка модерації неамериканського контенту на Facebook відбувається через підрядників, які є наближеними до регіонального контексту, з яким вони працюють. Підрядники у цьому контексті – це сторонні організації, які модерують контент, спрощуючи операційну діяльність центрального офісу. Загалом, через динамічне зростання Facebook протягом останнього десятиріччя (дохід компанії в період 2012-2022 рр. зріс на 5819%) виникла потреба перекласти частину роботи на сторонні організації, зокрема і модерацію контенту. The Wall Street Journal підрахувала, що з 2016 по 2021 роки кількість працівників зі сторонніх організацій зросла в 10 разів – з 10 тисяч до майже 100 тисяч. Це навіть більше, ніж кількість найманих працівників у самій Meta – їх, станом на 2021 рік, було близько 60 тисяч.

Рішення збільшити “зовнішній штат” є логічним з огляду на чисельність аудиторії платформи. Наприклад, контентом у Субсахарській Африці декілька останніх років займалася компанія Sama, на зміну якій наприкінці 2022 року прийшла Majorel (через що у Кенії досі триває судовий процес, пов’язаний з умовами праці та надання послуг третьою стороною).

Іншим регіонам може не так щастити на увагу: велику кількість контенту на Facebook модерують або модерували такі всесвітні IT-гіганти як Cognizant, Genpact або Accenture. Вони, у свою чергу, можуть переносити цей процес у регіональні офіси або у Філіппіни (країна, яка загалом є популярним напрямом для аутсорсу IT-послуг), або деінде. І саме тут постає один з найважливіших елементів у всьому ланцюгу модерації контенту – умови праці модераторів.

Тривалий час ця історія залишалася в тіні та з’являлася у фокусі лише завдяки анонімним модераторам, які порушували Non-Disclosure Agreement (NDA, договір про конфіденційність) та ділилися з медіа досвідом роботи у Facebook. Переважно це стосувалося працівників у США, але завдяки цим фактам можна зробити припущення про умови роботи і в інших країнах. Загалом, умови були такі: зарплата, удвічі нижча за середню у США, повний робочий день з постійним переглядом контенту на кшталт дитячої порнографії, вбивств, конспірологічних теорій та мови ненависті з невеликими 15-хвилинними перервами протягом зміни. У більшості випадків фахова допомога з питань ментального здоров’я відсутня. Багато колишніх працівників переживають ПТСР, а в одному випадку була зафіксована смерть на робочому місці від серцевого нападу. Контекст умов праці – це недооцінений фактор під час розгляду модерації контенту на Facebook, адже він прямо впливає на результат роботи всієї системи. Більше того, у таких умовах складно вимагати якісної модерації складніших питань, які потребують заглиблення в політичний контекст.

З іншого боку, що відбувається всередині центрального офісу Facebook? Згідно з розслідуванням “The Facebook Files” від The Wall Street Journal, існують певні суперечності між командами розробників і департаментами, відповідальними за рекламу на платформі. Одне з таких протиріч далося взнаки у 2018 році, коли компанія реформувала стрічку новин, яка відтоді базується на «релевантному» контенті, покликаному глибше залучити користувачів на основі їхніх вподобань. Інженери, відповідальні за безпеку на Facebook, не відреагували на цю ідею схвально. Їхня аргументація побудована навколо того, що подібна стрічка новин потенційно може генерувати багато шкідливого контенту та сприятиме поляризації суспільства як у віртуальному просторі, так і в реальному житті. Натомість люди, відповідальні за рекламу, стверджували, що шкідливий контент все одно прибирають, адже Facebook вдається з ним успішно боротися. Така стрічка новин – вдала тактика для монетизації (за 2022 рік 97% доходу Meta склалареклама, а це 113.6 млн доларів США). Попри це, реклама та алгоритмічна стрічка новин на Facebook часто таки мають шкідливий характер, розповсюджуючи дезінформацію або мову ненависті.

Іншим виміром конфлікту є оптимізм топ-менеджменту відносно штучного інтелекту (ШІ). У березні 2021 року працівники Facebook підрахували, що ШІ прибирає лише 3-5% контенту з мовою ненависті та 0.6% контенту, що стосується частини «Насильство та підбурювання» у Стандартах спільноти. ШІ не завжди розпізнає відео з реальною стрільбою (так, наприклад, Брентон Таррант, який у 2019 році вбив 51 людину в мечетях Крайстчерча, вів пряму трансляцію стрілянини на Facebook), але може видаляти контент зі страйкболом чи пейнтболом. Ще більше проблем виникає, коли графічне насильство відсутнє, але йдеться про складнішу історію політичної взаємодії різних суспільних груп. Це підтверджується низьким рівнем ефективності ШІ проти мови ненависті, опублікованої неанглійською мовою (прикладом слугує контекст арабської мови на платформі, яку Facebook часто помилково інтерпретує). У випадку з М’янмою, алгоритми компанії спровокували організоване насильство відносно етнічної групи рохінджа, що призвело десятків тисяч жертв.

Дійсно, ШІ може бути ефективним проти графічного контенту за умови відповідних інвестицій та адекватного навчання, але такі речі, як дезінформація чи мова ненависті, мають бути предметом розгляду людей. Такий розподіл потенційно сприятиме як підвищенню ефективності модерації, так і ментальному здоров’ю модераторів.

Інвестиції в модерацію контенту. Інвестиції у цьому контексті мають широкий сенс – як грошові, так і негрошові. Понад 90% користувачів Facebook живуть поза США та Канадою. Натомість близько 87% часу працівників компанії та підрядників, задіяних у модерації, спрямовано саме на ці дві країни. Відповідно, 90% користувачів платформи отримують лише 13% уваги модераторів – наслідок певного “американоцентризму” компанії. Він проявляється і в тому, що Стандарти спільноти до певного часу не були перекладені багатьма мовами, присутніми на Facebook. Всередині компанії розуміють цю проблему та за останні роки діють у двох напрямах:

- перекладають Стандарти спільноти;

- наймають нових модераторів зі знанням мов, які для Facebook історично були “білими плямами”.

Це потребуватиме часу та тісної взаємодії з місцевими стейкхолдерами (урядами або громадськими організаціями) задля максимальної ефективності модерації контенту. Адже з одного боку компанія має відносно гомогенну англійську мову та тривалий досвід взаємодії з нею, а з іншого – десятки діалектів арабської мови або строкату у мовному плані Африку.

Кейс-стаді

Ефіопія та Кенія

Історія модерації контенту в Ефіопії нерозривно пов’язана з Кенією, адже саме в кенійській столиці Найробі розташований офіс основного підрядника Facebook з модерації контенту в Африці – Sama. Наприкінці 2022 року кенійська правозахисна організація Katiba Institute та ефіопські дослідники Фіссеха Текле та Абрахам Меарег подали в суд на Meta через дотичності компанії до розпалювання насильства на території Ефіопії під час війни у Тиграї (2020-2022 рр.). Серед найжорстокіших епізодів війни – різанина у Май Кадра, під час якої було вбито близько 600 цивільних. Загальна кількість жертв серед цивільного населення під час війни у Тиграї може становити 600 тисяч.

Якщо відкинути численні проблеми з контентом, який просував насильство на території Ефіопії, прикметним є один найбільш резонансний випадок. Серед позивачів є Абрахам Меарег, син Меарега Амаре – професора хімії, який став жертвою війни. Меарега Амаре жив у місті Бахр-Дар та належав до народу тиграїв – однієї зі сторін війни (сторонами були регіональний уряд регіону Тиграй та центральний уряд Ефіопії). Певний час він жив у столиці Ефіопії – Аддис-Абебі, а під час війни повернувся до рідного міста Бахр-Дар попри те, що воно перебувало у відносно небезпечній зоні. Згодом у Facebook з’явилися публікації з його адресою та іншими особистими даними, які супроводжувалися закликами до вбивства професора. 3 листопада 2021 року Меарега Амаре вбили перед своїм будинком посеред дня. Публікації з закликами до вбивства протрималися на платформі 8 днів після смерті професора попри те, що його діти зверталися до Facebook із проханням видалити цей контент.

Ця історія з вбивством стала одним з каталізаторів позову на 1.6 млрд доларів США проти Meta, судовий процес триває досі. Позивачі прямо вказують на відповідальність компанії за розпалювання ворожнечі. Більше того, паралельно з цим відкривається інший вимір проблеми – до 2021 року не існувало Стандартів спільноти амхарською мовою, державною мовою Ефіопії.

Власне, поява амхарської версії документу була спричинена іншим злочином – 29 червня 2020 року вбили Хачалу Хундесса – відомого ефіопського активіста. Мовна проблематика доповнюється тим, що основний підрядник Facebook з модерації контенту, кенійська компанія Sama, має в штаті близько 300 модераторів, які працюють з аудиторією у сотні мільйонів користувачів, які говорять багатьма різними мовами. Аби уникнути подібних випадків організованого, насильства Facebook має враховувати множинні регіональні контексти при модерації.

Розбитий танк на вулиці в Ідаґа Хамус, регіон Тиграй, Ефіопія (Yan Boechat, Voice of America)

Палестина, Туніс і Сирія

Якщо амхарська мова не входить до найпоширеніших у Facebook, то іншим прикладом є арабська – одна з найбільш вживаних на платформі. Поширений сценарій взаємодії арабомовних користувачів із Facebook – це блокування через підозри в тероризмі.

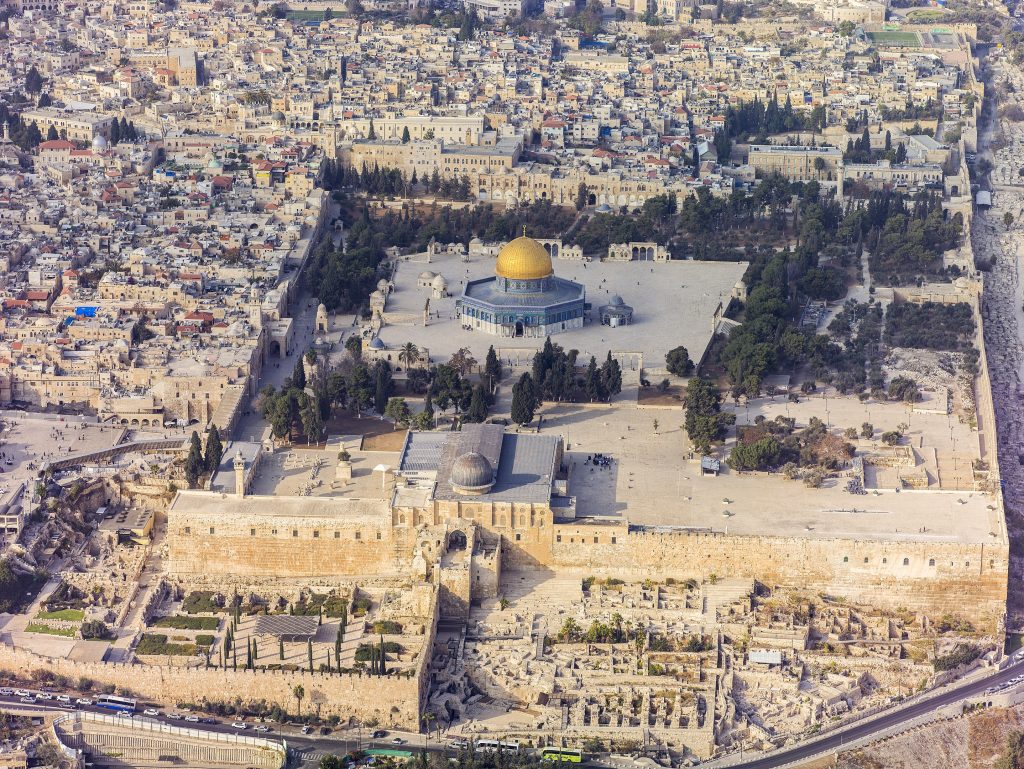

У цьому контексті прикметним є кейс Палестини у травні 2021 року, хоч він і стосується Instagram (соцмережа входить до Meta, як і Facebook). Це був період активних зіткнень ізраїльської поліції та палестинських мусульман біля мечеті аль-Акса в Єрусалимі – однієї з трьох головних святинь ісламу. В якийсь момент палестинські активісти, які хотіли привернути увагу світу до поліцейського насильства, помітили, що їхні публікації видаляються в Instagram. Платформа вказувала, що публікації порушують Стандарти спільноти в частинах “Небезпечні організації та особи” та “Насильство та підбурювання”. Згодом деякі публікації почали відновлювати. З’явилося й публічне вибачення від Facebook: причина полягала в тому, що алгоритми компанії переплутали назву мечеті з терористичною організацією “Бригади мучеників аль-Акси”.

Інший випадок стався в Тунісі, де в 2020 році соцмережа заблокувала 60 профілів місцевих журналістів та активістів без пояснення причини. Згодом Facebook прокоментував ситуацію та послався на “технічну помилку”, а за допомогою туніського довіреного партнера, громадської організації IWatch, акаунти відновили. Паралельно з цим Facebook проводив розслідування та заблокував близько тисячі сторінок і груп, афілійованих з UReputation – компанією з Тунісу, яка займалася запуском дезінформаційних кампаній для впливу на виборчі процеси в Тунісі, Того та Кот-д’Івуарі. Тим не менше, компанія ніяк не прокоментувала публічно цей “збіг” з паралельним видаленням профілів. У цьому кейсі помітно проблему з прозорою та чіткою комунікацією від Facebook, знайому користувачам з України.

Третій кейс стосується Сирії, де місцеві активісти, опозиційно налаштовані до правлячого режиму Башара Ассада, у 2020 році зіштовхнулися з масовим блокуванням сторінок та публікацій з певними хештегами через “тероризм”. Наприклад, під таку «тіньову» заборону потрапляли згадки Абдула Басета Ассарута – одного з лідерів сирійської опозиції, який загинув у 2019 році у боях проти сирійської урядової армії. За твердженням видання The Syrian Observer, Facebook видалили близько 10 тисяч акаунтів, які належали опозиційно налаштованим громадянам. Продовження цієї історії невідоме, адже немає ні офіційних коментарів Facebook, ні рішень наглядової ради Meta.

Мечеть Аль-Акса, яка у травні 2021 стала епіцентром сутичок між правоохоронними органами Ізраїлю та палестинськими протестувальниками (Andrew Shiva, Wikimedia Commons)

Індія

Індія, країна з 22 офіційними мовами, є найбільшим ринком для Facebook, а отже становить стратегічний інтерес для компанії як велике джерело доходу. Попри це, індійський Facebook також не є безпечним місцем. Основні проблеми, присутні в цьому сегменті – дезінформація та антиісламська мова ворожнечі.

У 2019 році працівниця Facebook використала звичну в компанії практику для відстеження шкідливого контенту на платформі – створила тестовий акаунт. “Піддослідним” у цьому експерименті був вигаданий житель штату Керала, що на півдні Індії. Протягом трьох тижнів тестовий акаунт ставив лайки публікаціям, які йому радила алгоритмічна стрічка новин. Серед цього контенту були новини з неперевірених джерел, меми з негативним образом пакистанців (у цей час відбувався прикордонний конфлікт Індії та Пакистану в Кашмірі) та загальна демонізація ісламу (порівняння мусульман зі “свинями”, фейкові уривки з Корану тощо). Більше того, в індійському сегменті Facebook є активна присутність парамілітарної організації “Раштрія сваямсевак санґх”, яка розпалює етнорелігійну ворожнечу в країні. Станом на зараз у Facebook є публічна сторінка цієї організації, яка має 5.4 мільйони підписників та статус верифікованого профілю. Інша схожа за ідеологією організація, “Баджранг дал”, також має багато регіональних сторінок, на які підписано по декілька десятків тисяч користувачів.

Хоча Facebook співпрацює з місцевими фактчекінговими компаніями, тренує алгоритми ШІ для 5 мов, поширених в Індії, та має модераторів, які працюють з іншими мовами, проблема етнорелігійної ворожнечі все одно залишається видимою складовою ландшафту індійського сегменту Facebook.

Хода парамілітарної організації “Раштрія сваямсевак санґх” (укр. “Союз добровільних слуг батьківщини”) (Suyash Dwivedi, Wikimedia Commons)

Висновки

Загалом, у країнах Глобального Півдня Facebook має ті самі виклики, з якими зіштовхується в домашніх (американських) умовах – мова ворожнечі, дезінформація чи розпалювання насильства. Інша сторона криється в тому, що за межами США та англомовних країн (і загалом умовного “Заходу”) Facebook стикається з регіональною специфікою: мовою, культурою, політикою та війнами. Власне, нерозуміння тих самих речей стає проблемою для компанії як на Глобальному Півдні, так і в Україні, а в більш широкому контексті – на будь-якому неангломовному ринку. Попри відданість ідеї безпечного віртуального простору та кроки у цьому напрямку (переклад Стандартів спільноти новими мовами, тренування та адаптація ШІ під культурно-політичні контексти, співпраця з фактчекерами, підрядування модерації регіональним акторам), “темна сторона” цієї соціальної мережі все одно лишається фактом. У зв’язку з цим може бути декілька напрямів, які могли б покращити досвід користувачів на платформі.

- Збільшення кількості підрядників, які ознайомлені з місцевим контекстом. Базова умова такої роботи – володіння мовою ринку, з яким працює модератор. В ідеальному світі ще однією умовою може бути знання локального контексту країни і розуміння її культури. Крім цього, важливою складовою є покращення умов праці модераторів: вищі компенсації за роботу та створення системи ефективної підтримки ментального здоров’я, адже така робота пов’язана з високим рівнем стресу.

- Інвестиції у тренування штучного інтелекту, спрямовані не на мову ворожнечі, а на графічні зображення насильства чи порнографії. Це дозволить розвантажити модераторів, які зможуть зосередитися на складніших темах, пов’язаних з політичною взаємодією в суспільствах.

- Прозора комунікація у випадку проблематичних історій на кшталт видалення акаунтів туніських активістів чи розпалювання насильства в Ефіопії. Створення Наглядової ради Meta у 2020 році – це один з продуктивних кроків у цьому напрямку. Інший вимір – це публічні коментарі топ-менеджменту компанії навколо ситуацій, які так чи інакше можуть шкодити репутації Facebook.

- Поглиблення співпраці з регіональними стейкхолдерами, як-от урядовими відомствами чи громадськими організаціями. Звісно, цей крок може грати і проти Facebook, якщо йдеться про взаємодію з авторитарними режимами. В ширшому контексті це питання цінностей та моральних пріоритетів топ-менеджменту компанії.

- Архівування шкідливого контенту. Дуже часто той чи інший контент може стати доказом відповідальності певних акторів за вчинення злочинів. Повне видалення публікацій та сторінок створює перепони для збору таких доказів. Такий інструмент міг би стати у нагоді юристам, дослідникам, активістам і журналістам, адже існують складності, пов’язані з ретроспективним збором даних, пов’язаних з проблемним контентом.

Кампус Meta у Менло-Парк, Каліфорнія (Fabio Isidoro, Wikimedia Commons)